Grid: a számítógép-hálózatok

új rendszere

Horváth Dezsõ

a fizikai tudomány doktora,

MTA KFKI Részecske- és Magfizikai Kutatóintézet, Budapest

és MTA Atommagkutató Intézet, Debrecen

horvath ![]() rmki . kfki . hu

rmki . kfki . hu

A grid eredete és célja

A számítástechnika gridrendszere intézményeken, esetenként országhatárokon átnyúló számítógépcsoport, a felhasználó számára egyetlen virtuális gép. Interneten keresztül osztja meg egy hatalmas rendszer számítástechnikai kapacitását adott szervezet felhasználói között. Fõként óriási processzor- vagy tárolókapacitást igénylõ (fúziós, nagyenergiás, asztrofizikai kutatások), illetve szétszórt információt használó (orvosi diagnosztika, meteorológia) alkalmazásokra épül. Gyakran hasonlítják az elektromos hálózathoz, a grid nevet is arról kölcsönözte: rengeteg áramgenerátor mûködik, de a felhasználónak nem kell tudnia, melyikbõl látják el. Ugyanakkor viszont a 220 V-ot mindenütt egyformán használjuk, amíg a különbözõ számítógép-felhasználók igényei a hardverrel és szoftverrel szemben erõsen különbözhetnek; emiatt a különbözõ közösségek virtuális szervezetekbe (Virtual Organization – VO) tömörülnek, amelyek egymástól függetlenek, habár használhatják ugyanazokat a gépeket: ez biztosítja a megfelelõ szoftverkönyvtár és adatállomány elérhetõségét a felhasználók számára és védelmét az esetleges hívatlan vendégekkel szemben.

A gridek létrehozásának oka a kisebb számítógépek alacsony kihasználtsága. Közkézen forgó (ám korántsem hivatalos) adatok szerint a nagy szervergépek foglaltsága mintegy 60 %-os, ellentétben a többfelhasználós Unix-szerverek 10 %-os és a személyi számítógépek (PC-k) 5 %-os kihasználásával. Már jóval a grid elterjedése elõtt felismerték, hogy egy PC-együttes a megfelelõ szoftverrel sokkal egyszerûbben és olcsóbban használható ugyanarra a célra, mint a szuperszámítógépek. Erre kitûnõ példa a CERN, a világ legnagyobb részecskefizikai kutatólaboratóriuma, amelynek magam is tizenhét éve veszek részt a munkájában. Húsz éve még a CERN sokezer kutatóját lényegében két bérelt szuperszámítógép szolgálta. A Cray-t tizenöt, az IBM VM-et tíz éve leadták, és elõször sokkal kisebb és olcsóbb, sokprocesszoros Shift-szuperszámítógépekkel és HP-klaszterekkel helyettesítették, majd azokat is együttmûködõ személyi számítógépek csoportjaival, PC-klaszterekkel váltották ki. Ma már ugyanis egy szuperszámítógép éves bérleti vagy fenntartási költségén nagyjából megvehetõ egy vele azonos kapacitású PC-klaszter. Ráadásul a számítógépek állandóan csökkenõ árát a szoftveré nem követi; a Linux elterjedése elõtt a kötelezõ szoftverfrissítés ára gyakran kényszerített bennünket arra, hogy lecseréljük az egész rendszert. A Linux viszont lényegében ingyenes, csak az esetlegesen felhasznált kereskedelmi programcsomagokért kell fizetnünk. Igazán mulatságos, hogy ugyanez a folyamat kezdõdik kicsiben a PC-k területén: a magasabb processzorsebességhez szükséges nagyobb áramok tápegység- és hõelvezetési problémái miatt a tendencia inkább több párhuzamos processzor beépítése ugyanabba a gépbe alacsonyabb sebesség mellett; ma már a laptopok is kétprocesszorosak, és az asztali gépek között egyre inkább terjednek a négyprocesszorosak.

Mint a számítástechnika legtöbb vívmánya (a világháló kivételével, amely CERN-i találmány), a grid is Amerikában indult. Létrehozása az Argonne Nemzeti Laboratórium három munkatársának nevéhez fûzõdik: Ian Foster, Carl Kesselman és Steven Tuecke a grid alapító atyái. Az általuk írt Globus szoftver volt az, amely lehetõvé tette, hogy különbözõ helyeken elhelyezett gépparkok a felhasználó számára egységes virtuális szervezetekbe (VO) tömörülhessenek, megfelelõ biztonsági védelemmel, és hogy a különbözõ VO-khoz tartozó felhasználók a szervezethez tartozó gépeket és programokat elérjék. Az elsõ demonstráció során, 1995-ben, két hétre egységes rendszerré kapcsoltak össze tizenhét nagysebességû hálózatot. Ennek a sikere megnyitotta az amerikai kutatási támogatást is: az amerikai védelmi költségvetés (mi más?) három éven át évi 800 ezer dollárral támogatta a Globus fejlesztését. Az R&D Magazine 2002-ben a Globus Toolkitet a legígéretesebb új technológaként nevezte meg. A Globust nyitott szoftvernek deklarálták, ami nagyban segítette annak széleskörû ellenõrzését és fejlesztését, és máig a legtöbb gridszoftver alapját képezi. Foster szerint a nyitottság nélkül nem terjedt volna el ilyen gyorsasággal, és az IBM, amely máig a legnagyobb kereskedelmi támogatója, sem vállalt volna a fejlesztésében olyan aktív szerepet.

A grid definíciója

A grid definíciójáról állandó viták dúlnak, a fõ kérdés általában az, mennyiben különbözik a világhálótól, illetve egy nagy PC-klasztertõl. A gridrõl remek magyar nyelvû bevezetõ olvasható a "> http://gridcafe.eu-egee.hu/ honlapon. Alapvetõ elvi jellegzetességei a következõk:

• Különbözõ helyeken található, osztott erõforrások használata automatikus gazdálkodással. A felhasználók feladatait ott hajtják végre, ahol szabad kapacitás van, mindezt a felhasználó számára átlátható módon. Ennyiben tehát konkrét intézmények határain (és tûzfalain!) átnyúló számítógép-klaszternek felel meg. A fentiek a lehetõ legésszerûbb kapacitáskihasználást eredményezik, hiszen például különbözõ idõzónák között kiválóan átkapcsolhatók a feladatok azokba, amelyekben vége a nagyobb terhelést jelentõ munkanapnak.

• Különbözõ helyeken található adatbázisok automatikus elérése. Ez a funkció a világhálóéra emlékeztet, hiszen ott sem kell tudnunk, honnan bányássza elõ a böngészõnk a szükséges információt. A fõ különbség itt az információ felhasználásában van: a külsõ adatbázis mérete vagy érzékenysége miatt nem azt viszik át a felhasználó gépére, hanem a felhasználó programja kerül az adatbázishoz hozzáférõ számítógépre, és csak az eredményt kapja vissza a programozó.

• Az összekapcsolt gépek operációs rendszereinek nem kell azonosnak lenniük, mint a klaszterek esetén. A grid alapszoftvere, a felhasználói program és a számításokat végzõ gépek operációs rendszere (többnyire valamilyen Unix vagy Windows) közötti kapcsolatot biztosító középszoftver (middleware) gondoskodik errõl. Ez utóbbi feltétel azonban nem mindig mûködik, hiszen sokkal egyszerûbb adott operációs rendszerhez rendelni a középszoftvert.

• A fentiekbõl következik a decentralizáltság: nincs fõgép vagy központ, mindegyik gridhez csatolt farm önállóan mûködik, csak feladatokat cserél a partnereivel.

A grid és a világháló közös vonása tehát a rejtett komplexitás: nem kell tudnom, honnan származik a felhasznált információ, hol mûködnek a közös programok; különböznek viszont az optimalizált kapacitáselosztásban, a kívánt adatok automatikus megkeresésében és használatában.

Tipikus gridalkalmazások

Habár, mint láttuk, a gridet ugyanúgy a (mag)fizikai kutatási szférában fejlesztették ki, mint magát a számítógépet vagy a világhálót, csak a kutatás miatt a grid sem terjedt volna el. A számítógépeket a játékok és a felhasználóbarát operációs rendszerek tették olcsóvá (erre gondoljunk, ha szidjuk a Windowst), a világhálót sem csak értékes ismeretek szerzésére használjuk. A grid ugyanúgy robbanásszerûen kezdett terjedni, mint a világháló. A világhálót 1989-ben fejlesztették ki a CERN-ben a nagyenergiájú kutatások számára, és 1994-ben már a Vatikán könyvtárát lehetett vele böngészni. Mint láttuk, a gridet 1995-ben álmodták meg és 1999 körül született meg a Globus. 2003-ban már a következõ sikeres grid-alkalmazásokat találtam a világhálón:

1. Oktatás, kutatás

• A Floridai Egyetem Advanced Computing and Information Systems laboratóriuma az egyetem szétszórt számítástechnikai kapacitását közös gridben egyesítette (Linux, saját fejlesztésû gridszoftverrel). Ezzel lehetõvé vált a helyileg szétszórt kapacitás biztonságos egyesítése és egységesítése, az egységesítés miatt erõsödött az egyetem különbözõ területeken dolgozó kutatói között az együttmûködés.

• Egy közepes nagyságú amerikai egyetem (Marist College) megbízható, stabil rendszert keresett a hallgatói laboratóriumok és a belsõ felhasználók részére. A grid bevezetése (Red Hat Linux, IBM Globus grid toolkit) nagyobb stabilitást és biztonságot eredményezett olyan rendszerrel, amely tetszés szerint és igen olcsón bõvíthetõ, könnyû üzemeltetni, és a diákok elõtt is igen népszerû lett.

• Kisebb szingapúri egyetem (Ngee Ann Polytechnic) hét hallgatói laboratóriumát kapcsolták össze gridtechnikával. Minimális befektetéssel a számítástechnikai felhasználói kapacitás a sokszorosára nõtt, mind a hallgatói, mind a kutatói számítások felgyorsultak, jelentõsen nõtt az egyetem presztízse.

• Tajvan kormánya gridrendszerrel kapcsolta össze az ország kutatóintézeteiben és egyetemein a nanotechnológia és élettudományok terén mûködõ kutatócsoportok számítógépeit a kutatási eredményesség javítására.

• A francia Nemzeti Magfizikai és Részecskefizikai Intézet (IN2P3) tíz, egymástól távol esõ kampusszal rendelkezik. A Unix-szerverek és Linux-klaszterek Globus-alapú gridösszekötésével a számítástechnikai infrastruktúra egységes lett, lehetõvé vált nagyléptékû szimulációk biztonságos végrehajtása, többek között az élettudományok területén.

2. Egészségügy

• A Pennsylvaniai Egyetem 2002-ben nemzeti digitális mammográfiai archívumot hozott létre gridrendszerben. Ez lehetõvé teszi diagnosztikai célból az ország bármely pontján felvett, nagyfelbontású képek letöltését vizuális és számítógépes összehasonlítás céljából 2-90 másodpercen belül, megfelelõ diszkréció és biztonság mellett. A módszer teljes elterjedése évente 5,6 petabyte adat tárolását jelenti, mivel egy-egy vizsgálat eredménye kb. 160 MB méretû. Az archívum használatához szükséges napi 28 TB-nyi adatátvitel csak a griddel oldható meg biztonságosan. Az európai MammoGrid projektet az EU 5. keretprogram keretében kezdeményezték 2001-ben a CERN koordinálásával, és az ALICE kísérlethez kifejlesztett gridszoftvert használta. Számos hasonló orvosbiológiai grid-rendszer született, és a CERN valamennyi hasonló programot egyesíteni próbálja a 6. keretprogram támogatta EGEE (Enabling Grids for E-sciencE) projekt keretében.

3. Nagyipar

• Shell: A már létezõ programok a földrengések elõrejelzésére és elemzésére lényegesen gyorsabban futnak griden, és az adott géppark használata sokkal megbízhatóbb, biztonságosabb. A kutatók munkája a felgyorsult válaszok miatt hatékonyabb.

• EADS (Európai Légügyi, Védelmi és Világûr-Társaság) a DataGridet használja mérnöki szimulációk felgyorsítására (Linux-alapú operációs rendszer Globusszal). A gridinfrastruktúra növeli a tervezõirodájuk hatásfokát, a Linux-rendszer pedig lehetõvé teszi a megszokott programok futtatását.

• Novartis: A gyógyszeripari óriásvállalat az IBM-mel együttmûködésben 2002-ben indította gridprogramját 3000 PC összekapcsolásával. A szimulációkkal jelentõsen csökkenthetõ volt az új gyógyszerek kifejlesztéséhez ténylegesen végrehajtott kísérletek száma.

4. Biztosítás, bankszektor

• NLI (Nippon Life Insurance): a gridtechnológia alkalmazása tizenkétszeresére növeli a kockázatbecslések sebességét: a korábbi 10 óráról mintegy 49 percre. Ez egyben lehetõvé teszi az eddiginél jóval bonyolultabb kockázati számítások elvégzését.

• RBC Insurance: A grid alkalmazásával a kockázatbecslési számítások felgyorsultak: egy szabványos, 2,5 órás számítás 10 percre, a hosszabb, 18 órás 32 percre rövidült. Ezzel a kérvények elbírálási ideje 97 %-kal csökkent, és lehetõvé vált többféle kiértékelési feladat végrehajtása a kockázat csökkentésére.

• A Wachovia Bank, befektetési és biztosító társaság gridrendszerben egyesítette számítógépparkját. A kockázati becslések végrehajtása nagyságrendekkel gyorsult, sokkal több szimulációt tudtak végezni, komplexebb vizsgálatokra nyílt lehetõség, a Linux alkalmazása miatt stabilabb lett a rendszer, és általában csökkent az infrastruktúra fenntartási költsége.

5. Szórakoztatás

• A Butterfly.net kaliforniai cég, amely internetes, sokszereplõs játékokat fejlesztett, árult és üzemeltetett Amerikában, Európában és Kelet-Ázsiában, internetes játékokhoz az IBM-mel együttmûködésben kifejlesztette a Butterfly gridet, amely két, 50 processzoros farmon mûködött. A gépeket nagysebességû üvegszálas hálózattal kötötték össze, lehetõvé téve a felhasználóknak, hogy a griden belül különbözõ szerverekkel lépjenek kapcsolatba. A cél az volt, hogy tetszés szerint bõvíthetõ, alacsony árú és üzemköltségû, megfelelõ gyorsaságú rendszert hozzanak létre. A megoldás „on-demand” alapú, Globus gridrendszerre épített számítógép-használat lett, linuxos PC-kkel, amely rendszer két év alatt a vállalati profit nyolcszoros növekedéséhez vezetett. Egy PC kiesésekor a rendszer automatikusan átviszi a futást egy másikra anélkül, hogy a játékosok azt észlelnék. A rendszer teljes kiépítésben egymillió szimultán játékost szolgált ki.

A gridhálózatok azóta viharos gyorsasággal terjednek, ebben is hasonlít a grid a világhálóra. Ma már a kutatás-fejlesztés, az egészségügy, a környezetvédelem, a vállalkozási szektor és az államigazgatás területén megszámlálhatatlanul sok gridrendszer mûködik. A továbbiakban bemutatunk néhány hazai példát.

BOINC

Parlagon heverõ házi számítógépek önkéntes felajánlásával mûködõ hálózatok régen mûködnek. Leghíresebb és legnagyobb a SETI@home (Search for Extraterrestrial Intelligence) hálózat, amely a földönkívüli civilizációk keresését segíti rádióteleszkópos adatok elemzésével, és csaknem egy évtizede mûködik (a Kaliforniai Egyetem kezdeményezte 1999 májusában): jelenleg 250 ország 1,7 millió számítógépe vesz részt benne. Szoftverét is Berkeleyben fejlesztették ki, a neve BOINC (Berkeley Open Infrastructure for Network Computing). A SETI céljáról és mûködésérõl a http://seti.index.hu/ honlapon olvashatunk.

Számos gridrendszer mûködik ma is BOINC alapon, általában valamilyen nagylélegzetû tudományos projekthez csatlakozva, a biológia, meteorológia, fizika és matematika területén. Jó áttekintés olvasható róluk a Wikipédiában: http://en.wikipedia.org/wiki/List_of_distributed_computing_projects. A biológiai témák között érdemes kiemelni a maláriakontrollt és a különbözõ fehérjevizsgálatokat, gyógyszermolekulák keresését.

A World Community Grid (WCG) programot az IBM indította 2004-ben igen általános tudományos programmal és többféle operációs rendszerre (Linux, Windows, MacOS és OpenBSD). Eddig 360 más szervezettel lépett kapcsolatba, és mintegy 300 ezer felhasználót sikerült megnyernie. Számos sikeresen lezárt projektje tudományos publikációval záródott az emberi örökítõanyag (DNS) szerkezetérõl, a rákkutatással és az izomsorvadás vizsgálatával kapcsolatban. Jelenlegi legnagyobb programjai a FightAIDS@Home és az AfricanClimate@Home .

A Magyar Tudományos Akadémia Számítástechnikai és Automatizálási Kutatóintézete (SZTAKI) hozta létre a DeskTopGrid rendszert. Ez a Linux-alapú hálózat is BOINC-alapon mûködõ, önkéntesen felajánlott PC-k sokasága, az egyetlen ilyen Magyarországon, pillanatnyilag 137 ország 62 ezer gépével ( http://szdg.lpds.sztaki.hu és http://www.desktopgrid.hu/ ). A DeskTopGrid-hez csatlakozók választhatnak tudományos és saját feladatorientáltság között; az elõbbi óriási kapacitást követelõ matematikai feladatokat old meg, jelenleg általánosított bináris számrendszereket vizsgál.

Magyar gridrendszerek

Az elsõ hazai gridrendszer a Nemzeti Informatikai Infrastruktúra Fejlesztõ Intézet (NIIFI) által alapított KlaszterGrid rendszer volt. Kilenc magyar egyetem hallgatói számítástechnikai laboratóriumából hozták létre 2003-ban, és máig huszonhárom felsõoktatási intézmény harminc intézete csatlakozott hozzá. Mivel a hallgatók a mintegy 1300 gépet csak nappal használják, a Windows-alapú gépparkot fotelágyszerûen (nappal szék, éjjel ágy) a munkaidõ végeztével újraindítják Linuxban, és gridként mûködik (Condor-pool). A rendszer leírása, a hozzáférési lehetõségek és a felhasználási módszerek megtalálhatók a http://www.clustergrid.niif.hu honlapon.

A Veszprémi Egyetem a Java-alapú JGrid rendszer fejlesztésében vesz részt a Sun Microsystems, az ELTE Informatikai Kara és a SZTAKI részvételével ( http://pds.irt.vein.hu/hu/jgrid/about ).

Az MTA Részecske- és Magfizikai Kutatóintézete (RMKI) hazánkból 2003-ban elsõként csatlakozott nemzetközi gridrendszerhez, a CERN nemzetközi részecskefizikai laboratórium 2008-ban elkészülõ proton- és nehézion-gyorsítója, a Nagy hadron-ütköztetõ (LHC) adatainak kezelésére létrehozott Worldwide LHC Computing Grid (WLCG, http://www.lcg.cern.ch ) rendszeréhez egy százprocesszoros PC-farmmal BUDAPEST néven. Mivel az LHC-ból fizikai adat csak 2008 után várható, az RMKI a SZTAKI közremûködésével létrehozta, és üzemelteti a HunGrid rendszert, hogy lehetõvé tegye a teljes magyar akadémiai kutatóközösség számára a BUDAPEST klaszter használatát. A HunGrid-et jelenleg az RMKI-ban száz dedikált processzor szolgálja, és az Eötvös Loránd Tudományegyetem (ELTE) Informatikai Kara is csatlakozott hozzá egy húszprocesszoros gépparkkal.

A magyar gridtevékenység koordinálását a Magyar Grid Kompetencia Központ (MGKK) végzi, tagjai a SZTAKI, a NIIFI, az ELTE, a Budapesti Mûszaki és Gazdaságtudományi Egyetem (BME) és az RMKI. Az MGKK tagintézményei alapító tagként csatlakoztak a CERN által indított Enabling Grids for E-sciencE (EGEE) programhoz, amely jelentõs EU-támogatással már a harmadik periódusban fejleszt egy reménybeli egységes európai gridrendszert.

CERN és LHC

A CERN az európai országok közös kutatóintézete (2. ábra), a világ legnagyobb részecskefizikai laboratóriuma. Gyorsítóit és egyéb szolgáltatásait 2500 alkalmazott, fõként mérnök és technikus üzemelteti, és 250 partnerintézet mintegy 6500 fizikusa használja; ez a világ részecskefizikusainak mintegy fele. Érdekesség, hogy a felhasználók száma szerinti két legnagyobb ország, az USA és Oroszország, nem tagállamok, a CERN fenntartásához esetenkénti hozzájárulást fizetnek.

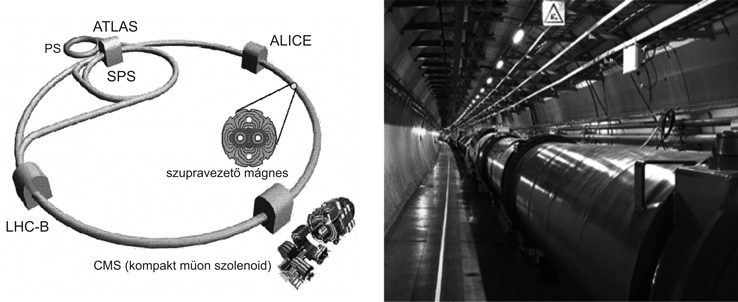

A CERN legnagyobb berendezését, a világ mind mérete, mind teljesítménye szerinti legnagyobb gyorsítóját, a Nagy hadron-ütköztetõt (Large Hadron Collider – LHC) idén helyezik üzembe, és jövõre kezd a kísérletezõk számára adatot szolgáltatni (3. ábra). 100 m mélyen a föld alatt fekvõ, 27 km hosszú alagútjában (4. ábra) négy óriási és több kisebb kísérlet fog mûködni. Magyarország jelentõs erõkkel a CMS (Compact Muon Solenoid) részecskefizikai és az ALICE (A Large Ion Collider Experiment) nehézionfizikai kísérletben vesz részt.

A CERN-rõl és kísérleteirõl sok információt találunk a Wikipédia magyar nyelvû CERN-oldalain ( http://hu.wikipedia.org/wiki/CERN ), valamint, természetesen, a CERN honlapján ( http://www.cern.ch ).

Az LHC eddig soha nem látott energiájú, 7 TeV-es protonnyalábokat fog egymással ütköztetni. Fõ célja a jelenlegi anyagelmélet, a Standard modell egyetlen még meg nem figyelt alkatrészének, a Higgs-bozonnak felfedezése, illetve esetleges új fizika feltárása. A protoncsomagok 40 MHz frekvenciával fognak egymással találkozni a detektorok középpontjában, és találkozásonként 15–25 proton–proton ütközés várható. Tudományosan érdekes esemény persze ritkán keletkezik majd; egy Higgs-bozon várható megfigyeléséhez, például, 1013 eseményt kell észlelnünk. Mivel egy esemény mérete 1 MB körüli, ez teljesen lehetetlennek tûnik megfelelõ, igen gyors elõzetes eseményválogatás nélkül. Így is, az LHC detektorai mintegy 10–15 petabájt (1 PB = 1015 bájt) mért adatot fognak évente elõállítani, amelyhez hozzájön még mintegy ugyanannyi szimuláció.

A WLCG-hálózat

Az LHC-termelte adatmennyiséget öt kontinens 250 társult intézményében fogják feldolgozni. Az adatok kezelésére a CERN létrehozta a WLCG- (Worldwide LHC Computing Grid, 6. ábra) hálózatot, amely rétegekbõl (Tier) áll. A CERN, természetesen, a központ, a Tier-0, vagy T0. Nem célszerû és nem is biztonságos az adatokat egyetlen helyen tárolni, minden kísérletnek lesz tehát néhány elsõdleges adattároló (T1) és sok másodlagos adatfeldolgozó (T2) centruma. A CMS-kísérlet (5. ábra), amelyben a legnagyobb létszámú magyar csoport dolgozik (harminc magyar a mintegy 2300 résztvevõ között) Karlsruhéban (Németország), Oxfordban (Anglia), Bolognában (Olaszország), Barcelonában (Spanyolország), a Fermilab-ban (USA), Lyonban (Franciaország) és Tajpejben (Tajvan) fogja az adatait tárolni, ezek tehát a CMS T1-centrumai. A T2-állomások valamelyik T1-hez csatlakoznak. A magyar T2 például, az RMKI BUDAPEST-nek keresztelt gridállomása, történeti okokból eredetileg közvetlenül a CERN T0-hoz csatlakozott, de távlatilag a bolognai T1-hez fog tartozni. A T1-centrumnak 2,2 PB aktív tárolókapacitással (mágnesszalag és diszk) kell rendelkeznie. A T2-k követelménye mintegy 300 CPU és 200 TB tároló, ezt a magyar T2-kapacitás jövõre remélhetõleg el fogja érni (a cikk megírásakor a 2008-ra tervezett CPU-kapacitásunk már megvan, a tárolót kell még bõvítenünk).

Az RMKI korai csatlakozásának köszönhetõ, hogy nálunk üzemel Közép-Európa egyetlen Resource Brokere, a grid feladatelosztó állomása. Ugyancsak a korai csatlakozás kényszerített bennünket arra, hogy létrehozzuk Magyarország elsõ gridfelhasználói jogosítványt nyújtó Certificate Authority intézményét az RMKI-ban, hogy törvényesen tudjunk mûködni (addig a jogosítványokat Lyonból kellett kérnünk); ezt a feladatot hamarosan teljesen átveszi tõlünk a NIIFI.

Az LHC-adatok feldolgozásánál megjelenik a gridrendszer összes elõnye a hagyományos számítástechnikával szemben. A kísérletek szoftvere természetesen különbözõ, ráadásul nem szabad áthallásnak lennie a különbözõ kísérletek adatai és programjai között, a kísérletek tehát létrehozták az LCG-n belül a saját virtuális szervezetüket (VO – virtual organization). Én a CMS-kísérlet tagja vagyok, tehát a CMS VO-t használom. Ehhez regisztrálnom kellett magamat a LHC-griden és igazolnom a CMS-hez való tartozásomat. Ha analizálni szeretnék egy szimulált adathalmazt (az LHC még nem mûködik, az analíziseket szimulációkon optimalizáljuk), megadom az adatfile nevét, és beküldöm a programomat az LCG CMS-szervezetébe. A rendszer megkeresi, hol tárolják a kért adatokat, és odairányítja a programomat (a mi CMS-témánk esetében többnyire a CERN-be, a batáviai FERMILAB-ba vagy a bolognai számítóközpontba); a programom ott lefut, az eredményt pedig visszakapom saját itthoni szerveremen vagy PC-men. Mindehhez nem kell felhasználói jogosultságomnak lennie a külsõ gépparkon, nem is kell tudnom, hol fut le a programom.

Az EGEE-projekt

A CERN a kezdetektõl kezdeményezõ szerepet vállalt az európai gridhálózat fejlesztésében. Erre természetesen az elõzõ részben leírt LCG-rendszer kifejlesztése kényszerítette. Ugyanakkor számos párhuzamos fejlesztésben is segítségét kérték; erre a korábban már említett MammoGrid projekt jó példa, amely az ALICE LHC-kísérlet számára kifejlesztett gridszoftvert alkalmazta mammográfiai diagnosztika grides megoldására. Az elsõ átfogó projektet a különbözõ grid-rendszerek egyesítésére a CERN az 5. keretprogramon belül indította EDG (European Data Grid) néven. A projekt folyamatosan nõtt, egyre több intézmény csatlakozott hozzá, és 2004-ben már 36 millió euró támogatást kapott a 6. keretprogram keretében, EGEE (Enabling Grids for E-science in Europe) néven. Mivel a nem európai csatlakozók száma is nõ, az acronimból késõbb elhagyták Európát. Az EGEE-projektnek jelenleg 45 országból 240 intézmény tagja, közöttük a Magyar Grid Komptencia Központ öt tagja is. A 7. keretprogram keretében induló EGEE–3 magyar résztvevõi közös kutatócsoportban (Joint Research Unit) egyesültek, amelyet az RMKI koordinál.

Az EGEE támogat mind nemzeti, mind nemzetközi gridkezdeményezéseket. Alapelve, hogy a fejlesztést és létrehozást kell EU-pénzbõl támogatni, a géppark beszerzése és szinten tartása, az így létrehozott infrastruktúra üzemeltetése a felhasználó intézmények feladata kell legyen. Jelenleg az EGEE-hez a létrejött nemzeti és regionális gridszervezetek mellett, mint például a magyar HunGrid és a közép-európai VOCE (Virtual Organization of Central Europe) mellett jelenleg több mint hatvan nemzetközi gridprojekt van kapcsolatban az EGEE-vel. A CERN-i központ fejleszti a közös gridszoftvert (amely természetesen egyben az LHC-kísérletek közös szoftvere is), és azt az EGEE-partnerek saját gépparkjukon telepítik, és tesztelik. A CERN-ben számos magyar informatikus dolgozik ezen a területen.

Nem meglepõ az EGEE sikere, hiszen minden komolyabb számítástechnikai infrastruktúrát igénylõ felhasználónak érdeke, hogy a lehetõ legolcsóbban a lehetõ legnagyobb kapacitáshoz jusson, ennek kézenfekvõ megoldása a grid. Érdekesség, hogy az EGEE-közösség növekedése gyakorlatilag követhetetlen sebességû: a CERN EGEE-honlapján ( http://www.eu-egee.org ) minden lapon más szám szerepel a résztvevõ országokra és intézményekre.

Az RMKI gridállomása

Több jó okunk volt rá, hogy létrehozzuk az RMKI gridfarmját.

• Mindenképpen hozzá kell járulnunk a CMS- és ALICE-kísérletek mûködtetéséhez: a T2-farm fenntartása viszonylag olcsó hozzájárulás, hiszen nem kell hozzá állandóan Svájcban tartanunk résztvevõket.

• A megépült rendszer nem megy ki a CERN-be, hanem az itthoni infrastruktúrát fejleszti.

• A grid a számítástechnika élvonalában van, tehát hozzájárulunk vele az itthoni számítástechnikai kultúra fejlesztéséhez, és nem csak részecskefizikusok számára.

• Üzemben tartása viszonylag egyszerû, lényegében a résztvevõ fizikusok építették és üzemeltetik.

Az elsõ lépés az RMKI saját beruházása volt 2002-ben: huszonöt kétprocesszoros PC 1,8 TB tárolóval. Ez akkor elég volt ahhoz, hogy a telepítések után hetedik intézményként csatlakozzunk a CERN LCG-rendszeréhez, melynek ma már 250 tagja van. 2003-ban OTKA-pályázatból megdupláztuk a rendszert, majd az NKTH támogatásával felépítettük a szükséges környezetet (szünetmentes tápegységek, légkondicionáló, biztonságos beléptetõ rendszer). 2004-ben az MGKK többi intézményével együtt csatlakoztunk az EU EGEE-konzorciumához (a 6. keretprogram III-508833 és III-031688 jelû pályázatai), az segíti a berendezés fenntartását és továbbfejlesztését. Komoly segítséget nyújt az EU Marie Curie mobilitási programja is (ToK 509252). Részecskefizikai OTKA-pályázatok (T042864, T046095 és NK67974) is támogatják a rendszer fenntartását és fejlesztését. 2006-ban GVOP-pályázatból további húsz CPU-val és 5 TB tárolóval bõvítettük a rendszert, és a legnagyobb bõvítést 2007 folyamán az MTA elnöki keretébõl elnyert beruházási összegek tették lehetõvé: ma csaknem háromszáz CPU és 35 TB-nyi tároló van a rendszerünkben. A http://grid.kfki.hu honlapon igen sok információ található: tájékoztatás arról, hogyan csatlakozzunk hozzá, illetve használjuk a rendszert, és segítségével nyomon követhetõ, többek között, a rendszer pillanatnyi állapota és kihasználása is.

A HunGrid virtuális szervezet

Mint említettük, az LHC 2008-tól fog komoly adatmennyiséget termelni, addig a WLCG-rendszert csak szimulációk készítésére és analizálására, valamint adatátviteli tesztekre használjuk. Célunk az RMKI BUDAPEST-farmjának felépítésével az is volt, hogy ezt a kultúrát elterjesszük a magyar kutató közösségben, ahhoz azonban létre kellett hoznunk egy magyar virtuális szervezetet, a HunGrid VO-t. Ezt az RMKI és a SZTAKI kutatói szoros együttmûködésben végezték el. A HunGrid VO az RMKI gépparkján üzemel a SZTAKI-ban kifejlesztett PGrade felhasználóbarát felülettel, amely lehetõvé teszi a grid teljes körû használatát a köztes szoftver ismerete nélkül.

A HunGrid-rõl 2007 májusában felhasználói fórumot szerveztünk az RMKI-ban azzal a céllal, hogy megismertessük a HunGrid lehetõségeit gyakorló és potenciális felhasználókkal. A bevezetõ elõadásban Sipos Gergely (SZTAKI) ismertette a PGrade rendszert. Utána Kõvári Kálmán (RMKI) beszélt a grid használatával kapcsolatos biztonsági kérdések kezelésérõl; ez az ipari-kereskedelmi alkalmazásokban válik különösen fontossá, gondoljunk a bankszektorra. A felhasználókat három fizikus képviselte: Ódor Géza (MFA) fázisátmenetek vizsgálatára, Fodor Gyula (RMKI) elméleti számításokra, László András (RMKI) pedig nehézionfizikai analízisre és gravitációs hullámok szimulálására használta a HunGrid-rendszert. A fórum elõadásai megtekinthetõk a világhálón, a http://indico.cern.ch/conferenceDisplay.py?confId=15913 honlapon.

Érdeklõdõk a http://grid.kfki.hu/HunGrid-Registrar/index.pl oldalon minden információt megtalálnak arról, hogyan lehet HunGrid-felhasználóként regisztrálni. Ezúton is szeretnénk minden masszívabb számítástechnikai igénnyel megáldott magyar kutatót bátorítani, ismerkedjék meg a HunGrid rendszerrel, csatlakozzék a felhasználók (ma még meglehetõsen szûk) táborához.

Kulcsszavak: grid, számítógép-hálózat, párhuzamos rendszer, HunGrid, CERN, LHC

1. ábra • A World Community Grid (WCG) hálózat résztvevõi régiónként és a WCG FightAIDS@home projekt képernyõje

2.

ábra • A CERN környéke légifelvételen,

a nagy hadronütköztetõ

(LHC) 27 km kerületû

föld alatti gyûrûjével

2.

ábra • A CERN környéke légifelvételen,

a nagy hadronütköztetõ

(LHC) 27 km kerületû

föld alatti gyûrûjével

3.

ábra • Az LHC négy fõ

kísérlete;

4. ábra • Az LHC alagútja a szupravezetõ mágnesekkel

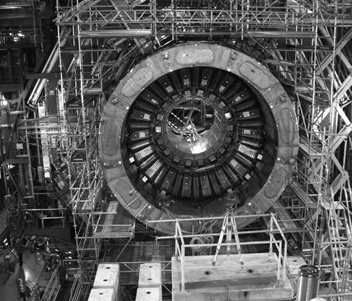

5.

ábra • A CMS-detektor építés

közben. A méretet a bal alsó sarokban dolgozó

technikus érzékelteti. Magyarok (a Debreceni

Egyetemrõl, az ATOMKI-ból

és az RMKI-ból) is részt vettek két

aldetektor megépítésében.

5.

ábra • A CMS-detektor építés

közben. A méretet a bal alsó sarokban dolgozó

technikus érzékelteti. Magyarok (a Debreceni

Egyetemrõl, az ATOMKI-ból

és az RMKI-ból) is részt vettek két

aldetektor megépítésében.

6.

ábra • A Worldwide LHC Computing GRID (WLCG) hálózat

túlnyomórészt a fõként

európai EGEE és az amerikai Open Science Grid

egyesülése. Az EGEE-t az Európai Unió

6. és 7. keretprogramjai támogatják. A WLCG

tagintézményei az LHC-kísérletek

virtuális szervezetein kívül valamennyi

tudományágat szolgáló nemzeti

gridprojekteket is üzemeltetnek, Magyarországon a HunGrid

virtuális szervezetet.

6.

ábra • A Worldwide LHC Computing GRID (WLCG) hálózat

túlnyomórészt a fõként

európai EGEE és az amerikai Open Science Grid

egyesülése. Az EGEE-t az Európai Unió

6. és 7. keretprogramjai támogatják. A WLCG

tagintézményei az LHC-kísérletek

virtuális szervezetein kívül valamennyi

tudományágat szolgáló nemzeti

gridprojekteket is üzemeltetnek, Magyarországon a HunGrid

virtuális szervezetet.

<-- Vissza a 2008/08 szám tartalomjegyzékére

<-- Vissza a Magyar Tudomány honlapra

[Információk] [Tartalom] [Akaprint Kft.]